最近被 RAG 刷屏了,这个概念理论来讲不是新概念;为了便于自己理解,也方便后续的产品规划,所以落成了这篇文章。

RAG 是什么?

RAG 全称 Retrieval Augmented Generation,中文名检索增强生成。翻译成人话就是 AIGC 在回答问题或生成文本时,从指定的文档库中寻找相关信息来生成回答或文本,从而提高其预测的准确度。

Recap:LLM 可将事实知识存储在参数中,但是它们获取和精确操纵知识的能力有限,因此在执行“知识密集型”任务时,性能落后于特定任务的模型。具体问题包括 LLM 可能存在 知识局限性、数据安全性、通用模型易产生 幻觉问题 ,解决方式为 In-Context Learning(Prompt Engineering)。

名词注解:

- 知识的局限性:现有的主流大模型的训练集基本都是构建于网络公开的数据,难以获取某一特定领域、实时性的、非公开的或离线的数据。

- 幻觉问题:在大模型自身不具备某一方面的知识或不擅长的场景,会产生幻觉问题。

- 数据安全性:完全依赖通用大模型自身能力的应用方案,需要将私域数据上传第三方平台,要在数据安全和效果方面进行取舍。

In-Context Learning 是随着语言模型规模不断提高后的新能力——通用的 “阅读理解” 能力。与模型训练和微调这类能“永久”改变模型认知的方法不同,In-Context Learning 是让模型“临时” 从 Context 中理解内容并产生回答。例如,想向 LLM 提问有关 Ray 文档的技术细节,可以先将全部文档输入 LLM 作为 Context 后再提问。 OpenAI GPTs的 “Knowledge” 功能即为 In-Context Learning,支持用户上传 PDF、Doc 等“知识库”作为 Context 来定制 GPT。

然而,LLM 支持的 Context Length 有限,最新的 GPT-4 Turbo 最大支持 128K context (约 300页 pdf),并且 Context Length 越大模型的推理效果越差、速度越慢。因此更有效的做法是,仅提供与 Prompt 有关的文档以缩短 Context Length,可通过“检索技术”实现,即 Retrieval-Augmented Generation, RAG。

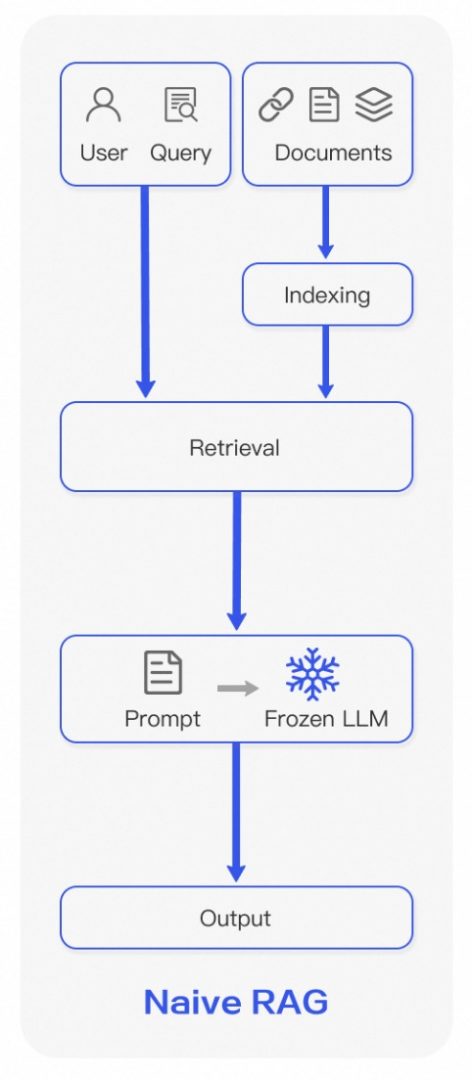

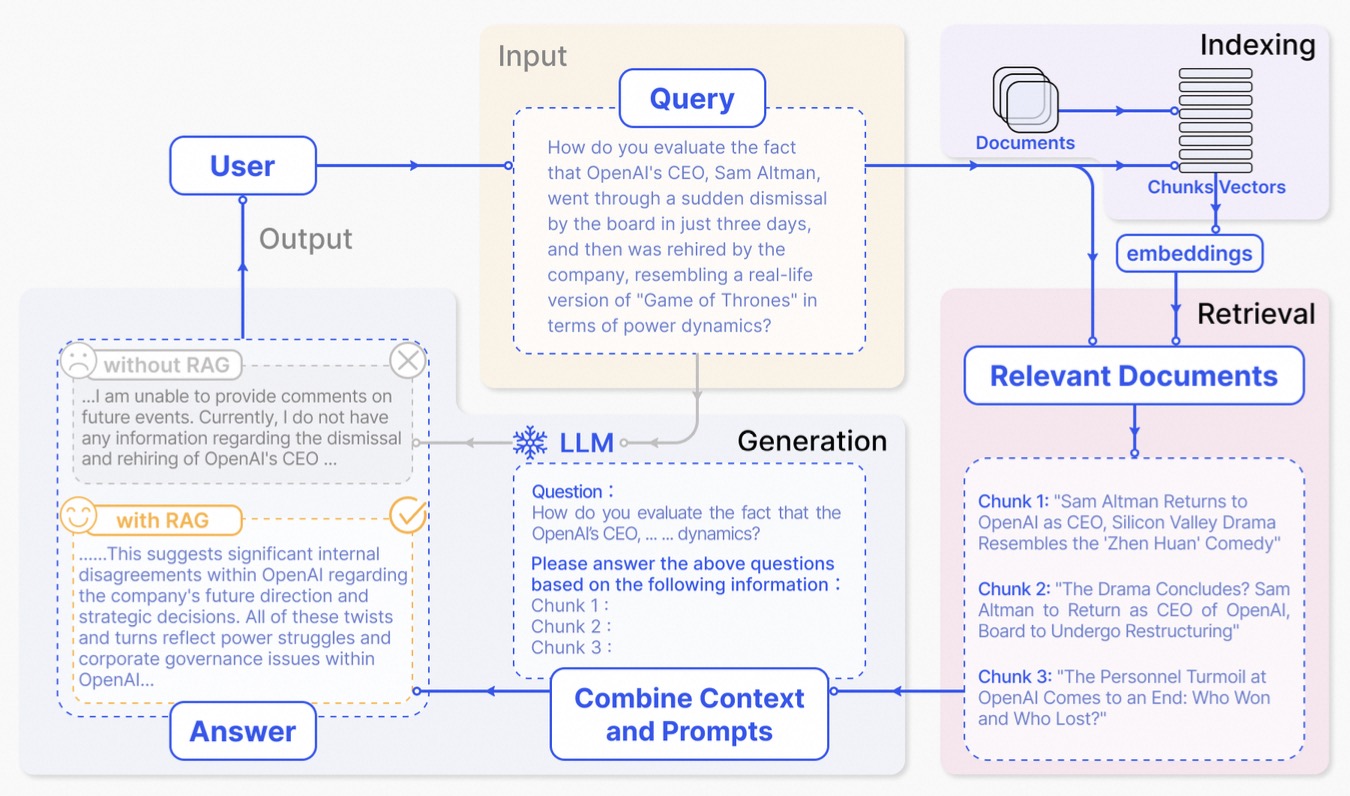

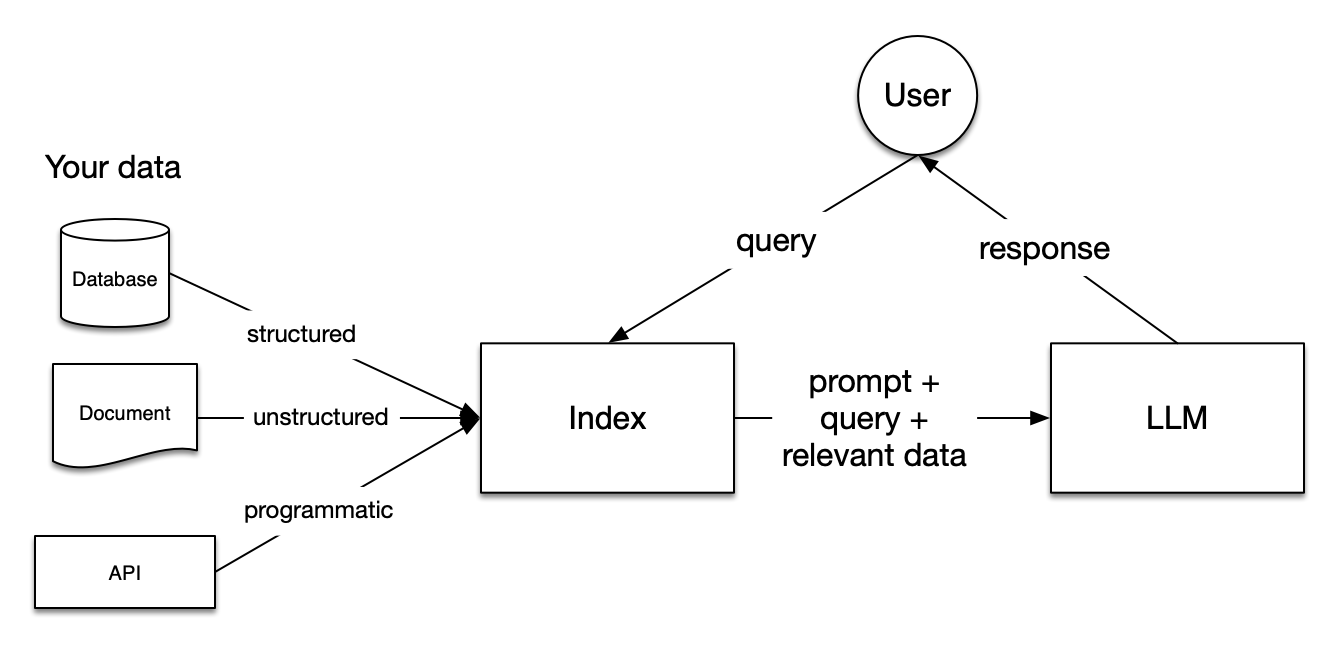

RAG 是 In-Context Learning 的子集,即通过“检索技术”进一步提高 Context 与 Prompt 的相关性,从而提高模型回答的准确性,其流程图如下:

RAG 的核心工作流程

1.索引(Indexing):

1. 数据准备:原始数据被清洗和提取,转换为标准化的纯文本格式。

2. 分块(Chunking):将文本分割成更小、更易于管理的块。

3. 向量化(Embedding):通过嵌入模型将块转换为向量表示,以便进行相似性比较。

4. 索引创建:创建一个索引,存储文本块及其向量嵌入作为键值对,以便高效搜索。

2.检索(Retrieval):

1. 查询转换:使用与索引阶段相同的编码模型将用户查询转换为向量表示。 2. 相似性计算:计算查询向量与索引库中向量化块之间的相似性分数。

3. 检索选择:根据相似性分数优先检索与查询最相关的前K个块。

3.生成(Generation):

1. 上下文融合:将查询和检索到的文档合并为一个丰富的提示,提供给LLM。

2. 响应合成:LLM根据这个上下文提示生成一个连贯的响应。

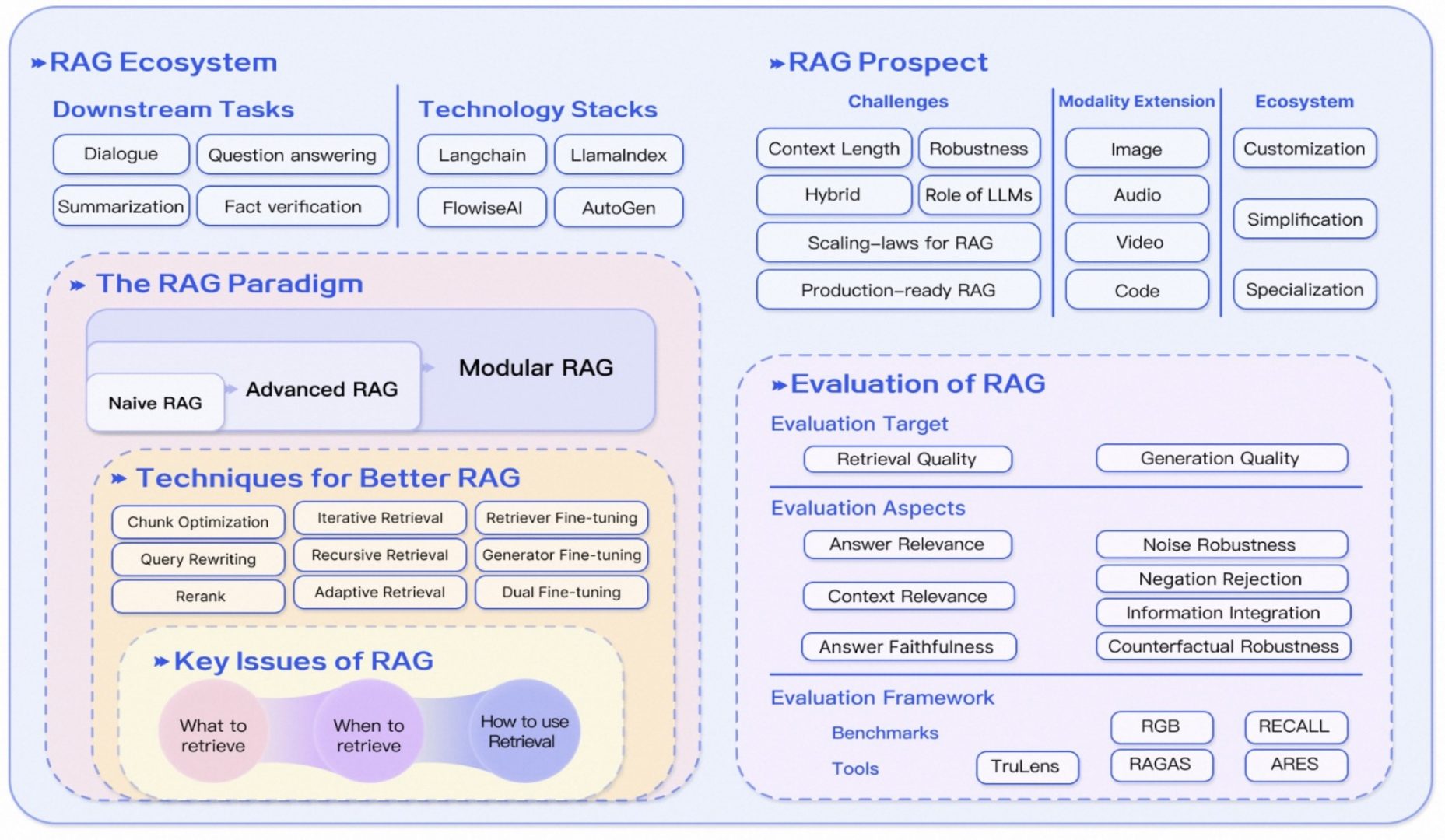

RAG 的发展历程

原始 RAG(Naive RAG) :

1.索引(Indexing):使用简单的索引策略,如基于文档的索引。

2.检索(Retrieval):采用基本的相似性检索方法,如基于向量的相似性匹配。

3.生成(Generation):直接使用检索到的信息作为上下文,指导语言模型生成响应。局限性:检索质量可能不高,导致生成的响应不准确或不相关。生成过程可能缺乏对检索信息的有效整合,导致输出质量不稳定。

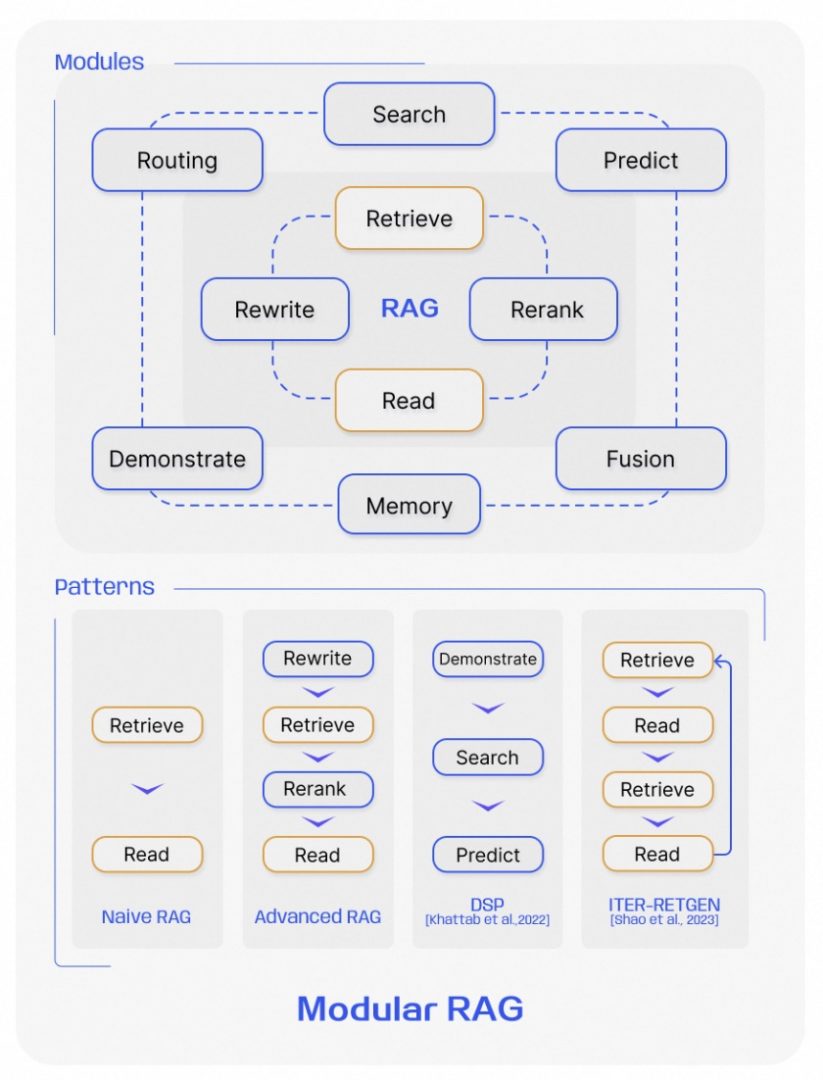

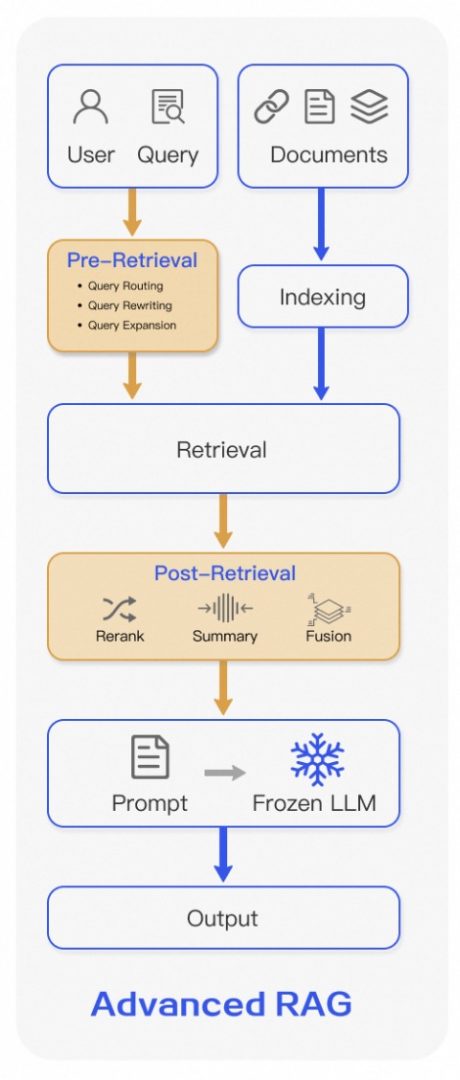

进阶RAG(Advanced RAG)

1.预检索策略:在检索前对数据进行优化,如使用query改写、滑动窗口、细粒度分割,优化数据索引,微调嵌入,动态嵌入

2.重排名(Re-ranking):对检索结果进行重新排序,以突出最相关的信息。

3.提示压缩(Prompt Compression):压缩检索到的信息,减少噪声,提高生成效率,压缩无关紧要的上下文,凸显关键段落,并缩短整体的 seqlen 以充分利用上下文窗口 改进:提高了检索的质量和效率;通过重排名和提示压缩等手段,优化了信 息的整合和生成过程。

模块化RAG(Modular RAG):

1.模块化架构:允许灵活地添加、替换或调整RAG过程中的模块,以适应特定问题

2.新模块和模式:引入了搜索模块、记忆模块、任务适配器等,以及优化 RAG 管道的新方法。

3.迭代和递归检索:采用迭代和递归策略来逐步深入地获取和整合信息。 愿景:提供了更大的灵活性和多样性,能够更好地适应不同的任务和数据类 型。允许序列化管道或端到端训练,提高了模型的适应性和性能。

RAG 的核心技术点 – Embedding 向量检索

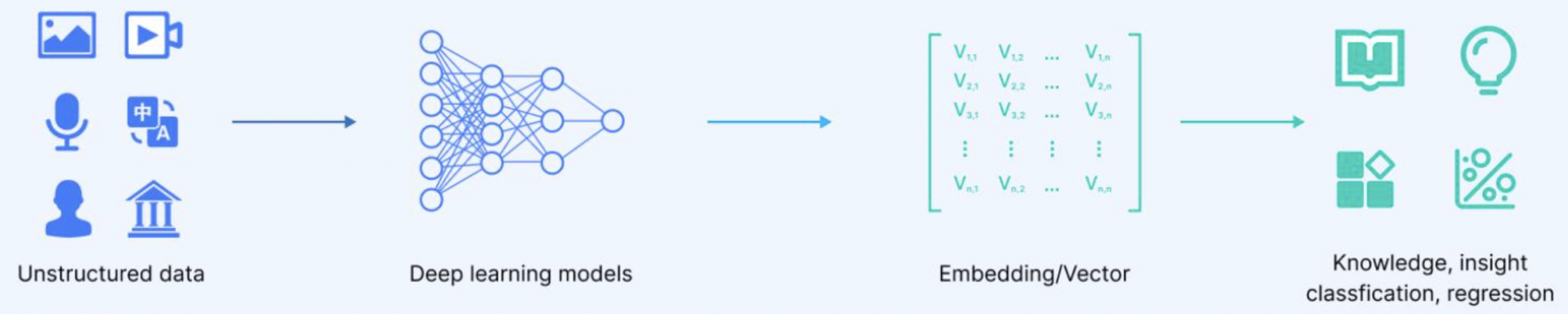

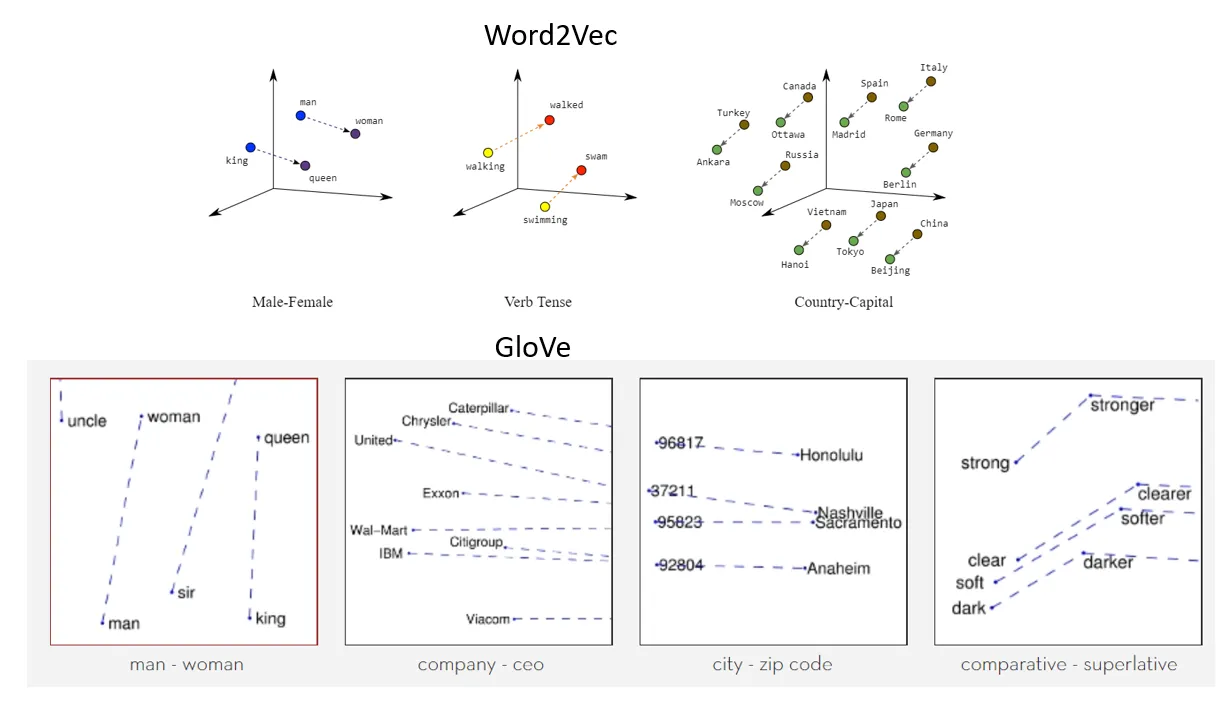

构建向量的核心为:将各类型数据通过 ML 模型映射至高维隐空间,空间向量即为 Embedding,使用向量间的“距离”表示相似度进行检索。 高维空间的 Embedding 蕴含了更丰富的信息,详细描述了数据特征及数据间的关系,如图所示。

以 text-to-embedding 领域为例,常见的预训练模型包括 word2vec, BERT等,最终 text 和 embedding 的关系如图所示。

Embedding 向量检索主要包含两个阶段:构建向量索引 和 向量检索。

构建向量

- 数据加载:数据源可能是 PDF、JSON、CSV等,数据类型可能为文本、图片等,后文以文本类型为例;

- 文档分块(Chunking):完整的文档会包含多个段落,每个段落所描述的概念不同,且会包含很多停用词(stop word)等无意义的单词,使用完整的文档计算 Embedding 难以精确描述文档内容。因此可以将文档分块(Chunking),每个分块独立计算 Embedding。 不同的分块方式决定了 Embedding 所表示的语义并最终影响 LLM 对文档整体的理解。例如文本文档可让 Chunk 间有一定的 overlap 保证上下文连贯性,而代码库由于代码除语义外也有结构关系,可将头文件、函数签名、函数体等代码内容分级后再切分(参考)。

- Chunk 向量化:将 Chunk 映射至高维隐空间向量,即 Embedding。Embedding 的计算可用自主部署的模型,如 hugging face提供的各类 embedding model,也可调用 Embedding Model 服务(可在 langchain.embeddingpackages 中查阅各类 Embedding Model API)。

- 向量索引构建 & 存储:为 Embedding 构建索引以便快速检索,与结构化数据的索引类似,Embedding 也有多种索引结构,例如下图的 k-nearest neighbor (knn) 构建图索引(Graph Index)。可用诸如 faiss的 lib 实现,但通常使用内置多种索引结构且提供持久化存储的向量数据库实现。

向量检索

根据用户 Prompt 检索出相关文档作为 Context

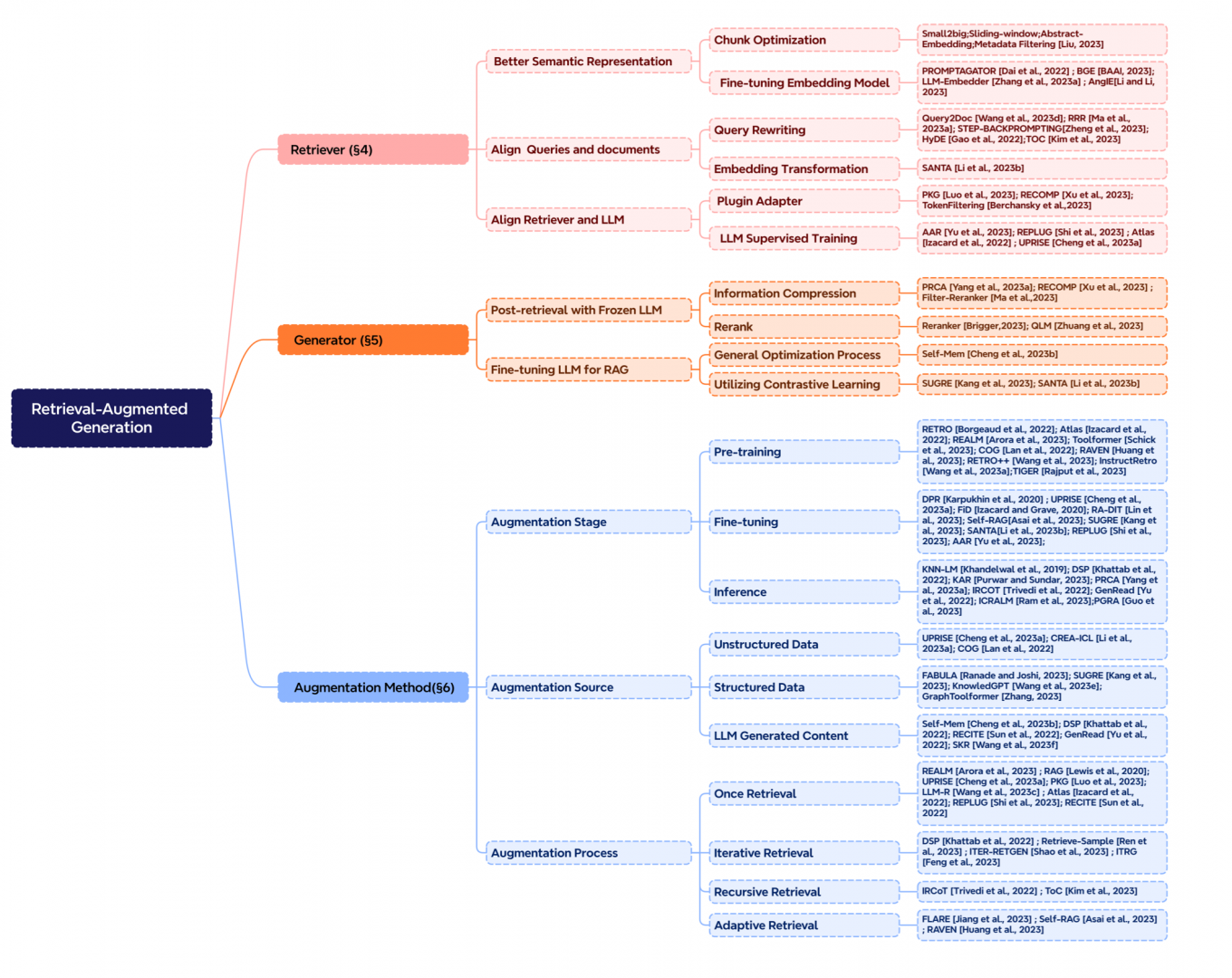

RAG 的核心技术点 – 更多参考

总结

本章介绍了 RAG ,一种基于检索技术的 In-Context Learning 方法,用于解决 LLM 训练数据更新不及时导致的各类问题,涉及的核心技术包括:Embedding 计算、 Embedding 相似度比较、向量索引构建等技术点。

主要资料来源:

Retrieval-Augmented Generation for Large Language Models: A Survey

– https://arxiv.org/abs/2312.10997

Seven Failure Points When Engineering a Retrieval Augmented Generation System

– https://arxiv.org/abs/2401.05856

Building Performant RAG Applications for Production

– https://gpt-index.readthedocs.io/en/latest/optimizing/production_rag.html

Retrieval-Augmented Generation for Knowledge-Intensive NLP Tasks

– https://arxiv.org/abs/2005.11401